IA y aprendizaje

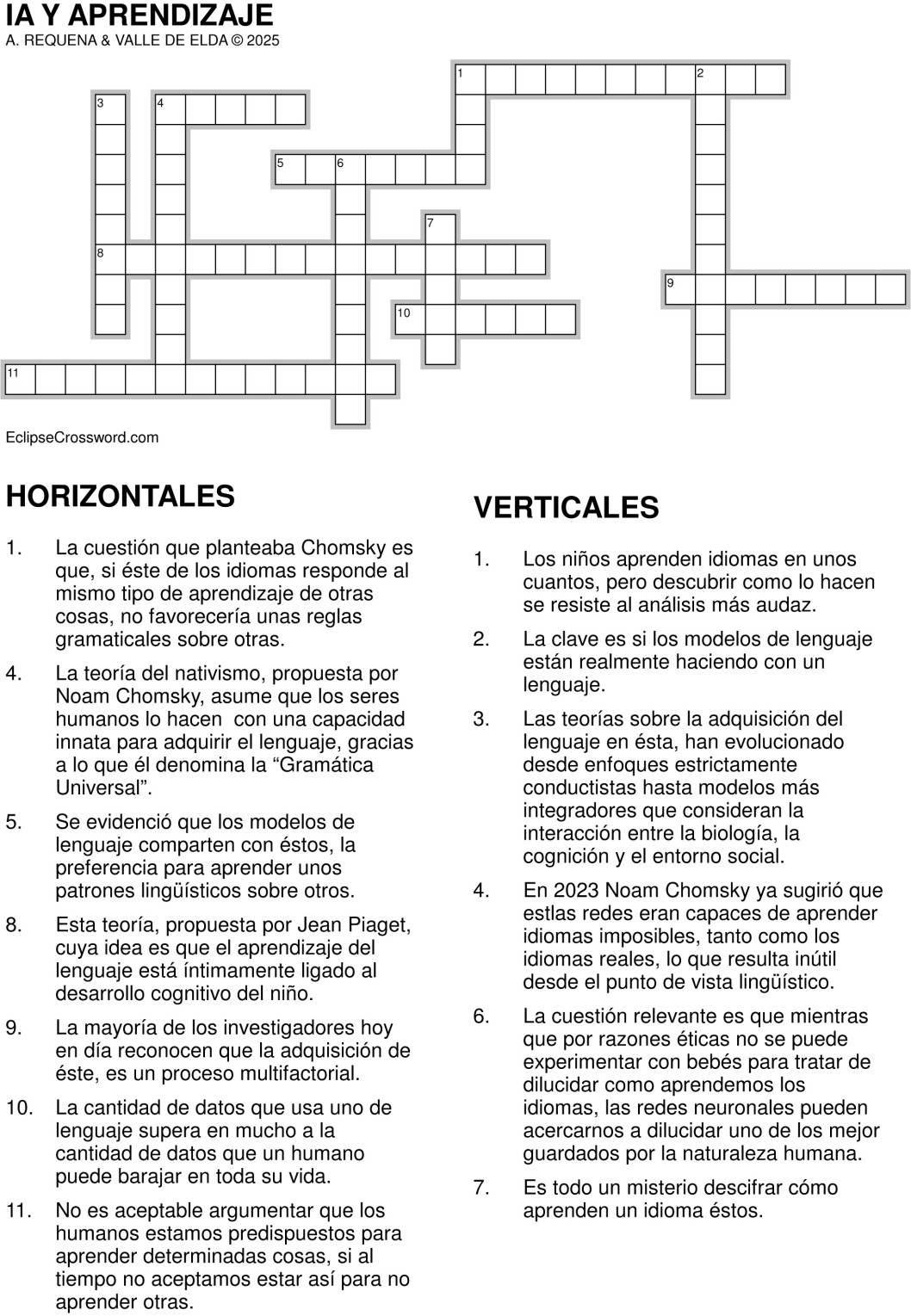

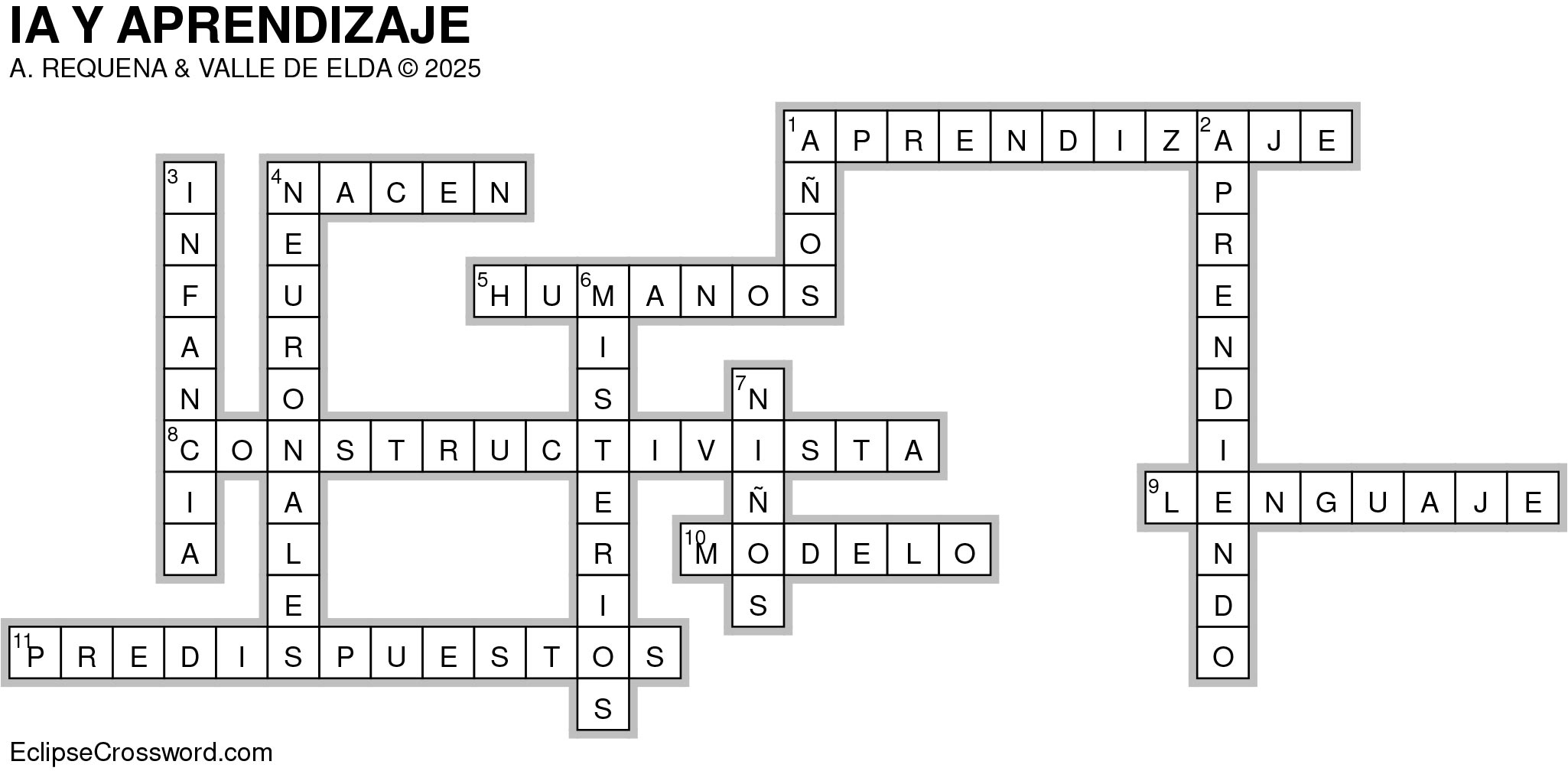

Es todo un misterio descifrar cómo aprenden un idioma los niños. La Inteligencia Artificial General está a la espera de descubrirlo. Los niños aprenden idiomas en unos años, pero descubrir como lo hacen se resiste al análisis más audaz. Se han formulado toda suerte de teorías al respecto, sin éxito reseñable. La teoría conductista, propuesta de B.F. Skinner y John B. Watson, basada en que el aprendizaje del lenguaje se basa en la imitación, la repetición y el refuerzo. Los niños aprenden a hablar reproduciendo los sonidos y palabras que escuchan, y las respuestas positivas (elogios, recompensas) consolidan el uso correcto del lenguaje. La del nativismo, propuesta por Noam Chomsky, cuya idea central es que los seres humanos nacen con una capacidad innata para adquirir el lenguaje, gracias a lo que él denomina la “Gramática Universal”. Esta teoría sostiene que, a pesar de la diversidad de lenguas en el mundo, existen estructuras comunes que facilitan la adquisición del idioma. La teoría del interaccionismo social, propuesta por Lev Vygotsky, Jerome Bruner y Michael Tomasell, basada en la importancia del entorno social y las interacciones con adultos y otros niños. Según esta perspectiva, el lenguaje se aprende a través de la comunicación social y el contexto cultural en el que el niño se desarrolla. Vygotsky, por ejemplo, introduce el concepto de “zona de desarrollo próximo”, en la que la interacción con interlocutores más competentes es crucial para el aprendizaje. La teoría constructivista, propuesta por Jean Piaget, cuya idea es que el aprendizaje del lenguaje está íntimamente ligado al desarrollo cognitivo del niño. Para él, a medida que el niño construye su conocimiento del mundo, también va estructurando y comprendiendo el lenguaje, lo que implica que la adquisición lingüística es parte de un proceso global de desarrollo intelectual. Los enfoques emergentes y conexionsitas, formulaciones recientes, cuya idea es que el lenguaje surge de interacciones complejas entre factores biológicos, cognitivos y ambientales. Los enfoques conexionistas, por ejemplo, utilizan modelos computacionales para simular cómo el cerebro procesa y aprende el lenguaje a partir de la exposición repetida a estímulos lingüísticos, sin necesidad de asumir estructuras innatas predefinidas.

La mayoría de los investigadores hoy en día reconocen que la adquisición del lenguaje es un proceso multifactorial que involucra tanto predisposiciones biológicas, como sugiere el nativismo, como la influencia del ambiente y las interacciones sociales, como destaca el interaccionismo social. Aunque cada teoría enfatiza distintos aspectos del proceso de aprendizaje, muchas investigaciones modernas combinan elementos de varias corrientes para obtener una comprensión más completa de cómo los niños adquieren el lenguaje.Se constata que las teorías sobre la adquisición del lenguaje en la infancia han evolucionado desde enfoques estrictamente conductistas hasta modelos más integradores que consideran la interacción entre la biología, la cognición y el entorno social. Cada una de estas perspectivas ha aportado valiosas ideas que, en conjunto, enriquecen nuestra comprensión del complejo proceso de aprender un idioma.

Los avances en el aprendizaje automático sugieren nuevas propuestas. Los modelos de lenguaje que están en la base de los sistemas de diálogo contemporáneos (los chatbots, como ChatGPT, DeepSeek u otros varios) han desplazado la investigación en lingüística. Veamos los perfiles nuevos y la utilidad en el campo de investigación del aprendizaje de idiomas. La clave es si los modelos de lenguaje están realmente aprendiendo un lenguaje. Todo parece apelar a la profundidad o superficialidad con la que desarrollan las tareas del aprendizaje automático. Chomsky opina que lo que hacen los modelos de lenguaje es algo superficial y no ofrece nada de interés a la lingüística. Publicó un artículo en 2023 en que pone de manifiesto que los modelos de lenguaje son irrelevantes en lingüística, porque dice, “aprenden demasiado bien”, porque pueden dominar idiomas imposibles de estructurar en reglas, en contraste con los de cualquier lenguaje humano conocido y lo hacen con la misma facilidad posible. El reto que supone esta valoración no se ha hecho esperar y unos lingüistas construyeron en 2024 una base de datos de texto en inglés para generar una docena de idiomas imposibles y descubrieron que los modelos de idiomas presentaban más dificultades en aprenderlos que en hacerlo con el inglés convencional.

En 2023 Noam Chomsky ya sugirió que las redes neuronales eran capaces de aprender idiomas imposibles, tanto como los idiomas reales, lo que resulta inútil desde el punto de vista lingüístico. El interés de esta afirmación es que la hace un investigador que basándose en las ideas de la informática teórica y la lógica matemática se dedicó en los años cincuenta del siglo pasado a buscar una estructura universal subyacente en todos los idiomas. La idea era muy sugerente, por cuanto implica que los humanos disponemos de una maquinaria específica para el procesamiento del lenguaje. Daba explicación a lo que se ha observado respecto a la existencia de reglas gramaticales simples que nunca aparecen en ninguno de los lenguajes conocidos. La existencia de reglas gramaticales simples que, sin embargo, no se observan en las lenguas naturales puede entenderse como el resultado de múltiples factores: limitaciones cognitivas, necesidades comunicativas, principios innatos de la Gramática Universal y procesos históricos y culturales de selección. En conjunto, estos elementos favorecen el desarrollo de estructuras lingüísticas que optimizan la comunicación, descartando aquellas reglas que, aunque, formalmente simples, no se ajustan a las demandas y restricciones del lenguaje natural. La cuestión que planteaba Chomsky es que, si el aprendizaje de los idiomas responde al mismo tipo de aprendizaje de otras cosas, no favorecería unas reglas gramaticales sobre otras. Si el aprendizaje de la lengua es especial, sería de esperar que los humanos tendríamos predisposición para ciertos idiomas y otros resultarían imposibles. No es aceptable argumentar que los humanos estamos predispuestos para aprender determinadas cosas, si al tiempo no aceptamos estar predispuestos para no aprender otras.

Con el aprendizaje automático se abre una nueva ventana. Los modelos de lenguaje están basados en redes neuronales que procesan datos respondiendo a conexiones que se establecen entre las neuronas que los articulan. La conexión entre neuronas cuantifica la fuerza de la misma, concretada en un valor numérico que es el peso de la conexión. El proceso de construcción de un modelo de lenguaje consiste en partir de un tipo de red al que se asignan pesos al azar para las conexiones. Con esta configuración inicialmente responde con tonterías. A continuación, se da paso al entrenamiento del modelo buscando predecir una palabra que colocar a continuación de una frase. Aquí es donde el trabajo se multiplica al tener que tratar grandes cantidades de texto. El sistema digiere el texto y pronostica la siguiente palabra y tras ello compara el resultado con el texto real y a partir de aquí puede ajustar los pesos de las conexiones entre las neuronas, toda vez que mejora las respuestas. Así es como aprende a generar frases.

Esta forma de proceder, no parece tener mucho que ver con el proceso que los humanos realizamos. La cantidad de datos que usa un modelo de lenguaje supera en mucho a la cantidad de datos que un humano puede barajar en toda su vida. Dicho esto, también es cierto que cabe la experimentación del aprendizaje de idiomas, al poder actuar de forma intervencionista, negado desde la ética para realizar con bebés humanos. Ciertamente hay una dificultad de partida consistente en que mientras que los sistemas basados en redes neuronales han triunfado en procesos poso relacionados con el procesado del lenguaje, no es menos cierto que el entrenamiento de las redes neuronales, está planteado al margen de todo lo que los lingüistas han investigado sobre la estructura de las oraciones.

Mitchel y Bowers emprendieron en 2020 una ruta prometedora para estudiar los modelos de lenguaje, inventando un lenguaje, no desde cero que podría introducir variables descontroladas e incluso demasiadas y sería difícil de seguir el proceso, sino manipularon un conjunto de datos de texto en inglés creando tres lenguajes artificiales que resultaban estar regidos por reglas extrañas. Par concretar la propuesta, por ejemplo, dividieron una frase en dos en una posición al azar y cambiaron el orden de las palabras en la segunda parte. Iniciaron el proceso con cuatro copias idénticas de modelo de lenguaje sin entrenamiento. A continuación, entrenaron cada uno de los modelos con datos distintos, tres idiomas imposibles y el inglés convencional era el cuarto. Finalizaron dando a cada modelo una prueba de gramática que aportaba nuevas oraciones del lenguaje en el que estaba entrenado cada uno de ellos. El resultado sorprendió, por cuanto los modelos entrenados con lenguajes imposibles eran casi tan precisos como el entrenado con el inglés. En suma, los modelos de lenguaje no distinguían entre idiomas posibles e imposibles. Chomsky sentenció en esta dirección en 2023, por tanto tres años después de la propuesta de Mitchel y Bowers.

La cuestión es que en el tiempo que transcurrió desde la propuesta inicial de Mitchel y Bowers al momento de la afirmación de Chomsky, las redes neuronales habían progresado y habría que probar con las redes de transformadores, hoy en la sala de máquinas de los modelos de lenguajes más eficaces, como propuso Kallini de la Universidad de California. Con un doctorando de Stanford, se puso manos a la obra. Concretaron que modelos de transformadores específicos había que ensayar y que idiomas probar. Probaron con GPT-2, propuesto en 2019 para ChatGPT. La virtud de esta red de transformadores es que es pequeña, más a escala humana que las posteriores. Muchos alineados con la postura de Chomsky pensaban que el transformador podía aprender cualquier cosa. Construyeron una docena de lenguas imposibles, al estilo de Mitchel y Bowers, dividiendo cada oración en grupos de tres palabras adyacentes e intercambiando la segunda por la tercera en cada grupo e incluso en un caso generaron un lenguaje completo al revés. Todos los idiomas imposibles comunicaban la misma información y el predictor no tendría mayor dificultad con los imposibles que con el posible. El resultado fue que el modelo entrenado en inglés convencional aprendió mucho más rápido y resultó más refinado que los demás con la excepción del modelo entrenado en el salto de palabra que se construyó reemplazando ciertos sufijos verbales con caracteres especiales a cuatro palabras de distancia. La conclusión fue que el lenguaje imposible era mucho más difícil de dominar. Los modelos de lenguaje no eran tan potentes como se suponía.

Se evidenció que los modelos de lenguaje comparten con los humanos, la preferencia para aprender unos patrones lingüísticos sobre otros. Tener preferencias nos trae a colación aspectos de la teoría de Chomsky sobre como aprenden los humanos. Al fin y al cabo, tanto los humanos como las redes neuronales son complicados y entender como difieren no resulta nada fácil. La aportación de Kallini y sus colegas fue identificar un principio que denominaron localización de la información que permite explicar por qué algunos idiomas son más imposibles que otros. Esto puede tener reflejo en la adquisición del lenguaje humano. Viene a establecer una referencia consistente en que el aprendizaje de idiomas tiene que ver con el diseño de la red neuronal. Distintas redes tienen diferente comportamiento, cosa que ya aportaron Mitchel y Bowers. Se investiga, usualmente, refinar los modelos retocando las redes subyacentes e identificar los ajustes más apropiados para mejorar el aprendizaje de idiomas ordinarios. Quizás sea interesante buscar ajustes capaces de empeorar el aprendizaje de los imposibles.

La cuestión relevante es que mientras que por razones éticas no se puede experimentar con bebés para tratar de dilucidar como aprendemos los idiomas, las redes neuronales pueden acercarnos a dilucidar uno de los misterios mejor guardados por la naturaleza humana.

Este blog pretende ser una depresión entre dos vertientes: la ciencia y la tecnología, con forma inclinada y alargada, para que por la vertiente puedan circular las aguas del conocimiento, como si se tratara de un río; o alojarse los hielos de un glaciar de descubrimiento, mientras tiene lugar la puesta a punto de su aplicación para el bienestar humano. Habrá, así, lugar para la historia de la ciencia, las curiosidades científicas y las audacias científico-tecnológicas. Todo un valle.

El eldense Alberto Requena es catedrático emérito de Química de la Universidad de Murcia.