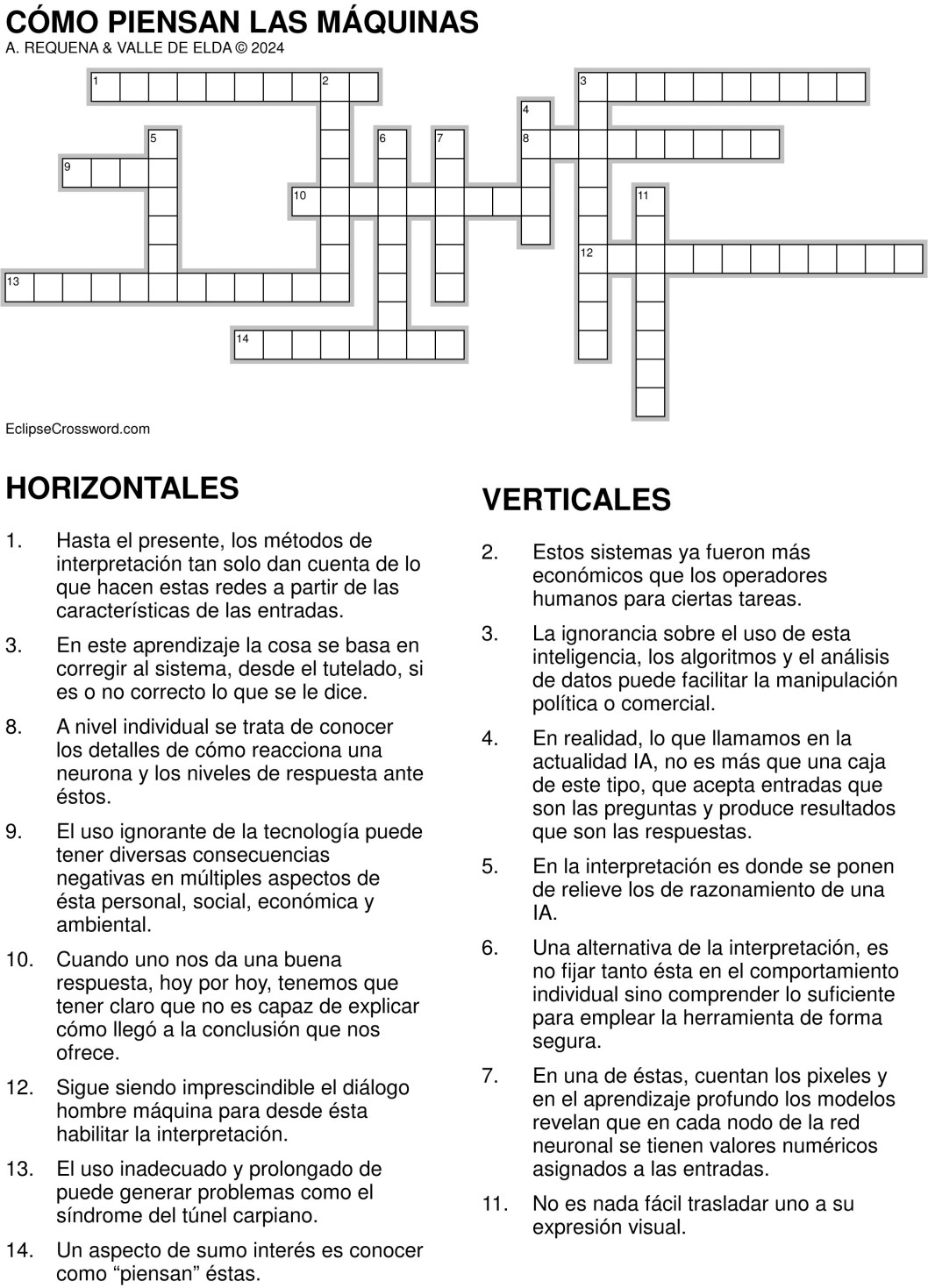

Cómo piensan las máquinas

El debate sobre este tema es necesario. Debe formar parte de la alfabetización imprescindible que trae de la mano la IA. El uso ignorante de la tecnología puede tener diversas consecuencias negativas en múltiples aspectos de la vida personal, social, económica y ambiental. Se advierte sobre riesgos de privacidad y seguridad, exposición de datos personales, no conocer prácticas de ciberseguridad puede facilitar el acceso de hackers a sistemas o dispositivos personales o falta de conocimiento sobre fraudes en línea puede resultar en pérdidas económicas. Pero, es más, porque el uso excesivo de dispositivos electrónicos, redes sociales o videojuegos puede afectar negativamente la salud mental y la interacción cara a cara puede disminuir debido a una dependencia excesiva de la comunicación digital; la falta de pensamiento crítico al consumir contenido en línea puede propagar información falsa o sesgada y el desconocimiento sobre cómo funcionan los algoritmos puede llevar a permanecer en "burbujas de filtro," lo que incrementa divisiones sociales. Por si fuera poco, el uso inadecuado y prolongado de dispositivos puede generar problemas como el síndrome del túnel carpiano, dolor de cuello o vista cansad y el uso irresponsable de las redes sociales puede contribuir a la ansiedad, depresión o baja autoestima. Puede tener repercusiones económicas porque la falta de conocimiento sobre marketing digital puede llevar a gastos innecesarios y no mantenerse actualizado en habilidades tecnológicas puede limitar oportunidades profesionales. Por otro lado, la ignorancia sobre el reciclaje de dispositivos electrónicos puede aumentar la contaminación ambiental; desconocer prácticas para optimizar el uso de energía en dispositivos puede contribuir al cambio climático. Es suma, la ignorancia sobre el uso de la inteligencia artificial, los algoritmos y el análisis de datos puede facilitar la manipulación política o comercial. Alternativamente, la educación y el uso consciente de la tecnología son esenciales para mitigar estos riesgos y aprovechar sus beneficios de manera responsable y ética.

Un aspecto de sumo interés es conocer como “piensan” las máquinas, lo que nos sumergirá en un baño de realismo benefactor para hacernos cargo del punto en el que nos encontramos. De forma expeditiva cuando un ordenador nos da una buena respuesta, hoy por hoy, tenemos que tener claro que no es capaz de explicar cómo llegó a la conclusión que nos ofrece. Las redes neuronales que están detrás de la IA y han transformado todo con un tratamiento complejo de los datos que permite identificar patrones en los datos y esa misma complejidad le impide en dar sentido a su funcionamiento interno. Las capas de neuronas artificiales que implican cientos de miles de conexiones no permiten identificar la forma de discernir las características que se concluyen. En realidad, lo que llamamos en la actualidad IA, no es más que una caja negra que acepta entradas que son las preguntas y produce resultados que son las respuestas, manejando una cantidad ingente de datos y descubriendo los patrones que les permiten resolver el interrogante formulado.

Hay investigadores que se ocupan de estudiar esta cuestión, que resulta ser clave para soslayar el momento crítico en el que nos encontramos, porque a nadie escapa la valoración de que es clave para aceptar si la tecnología IA es buena para nosotros o no. No cabe duda de que la clave radica en poder preguntar al sistema de IA cuando y qué conceptos ha empleado o descubierto en su “razonamiento”. Es la clave, saber qué y cómo interpreta la IA.

A nivel individual se trata de conocer los detalles de cómo reacciona una neurona y los niveles de respuesta ante los estímulos. Una alternativa es no fijar tanto la atención en el comportamiento individual sino comprender lo suficiente para emplear la herramienta de forma segura. Esta alternativa se basa en que el conocimiento con el que se ha entrenado el sistema, tiene un reflejo en el modelo que se ha implementado. Así se confirma que el modelo de aprendizaje está haciendo lo que debe y se espera que haga. Hasta el presente, los métodos de interpretación tan solo dan cuenta de lo que hacen las redes neuronales a partir de las características de las entradas. En una imagen cuentan los pixeles y en el aprendizaje profundo los modelos revelan que en cada nodo de la red neuronal se tienen valores numéricos asignados a las entradas. La cuestión es que los humanos no manejan estas claves. Un humano se fija en la imagen y la identifica con algo conocido o de las categorías usuales: animal, vegetal, cosa, etc. y no los valores que pudieran tener los píxeles correspondientes a las coordenadas RGB, pongamos por caso. Los humanos manejamos conceptos, las máquinas datos numéricos. Ahora bien, reconozcamos que “concepto” es un término poco claro. De hecho, no es nada fácil trasladar un concepto a su expresión visual, por ejemplo. ¿Cómo expresamos el cariño o el odio visualmente? La asunción de algo es un proceso que en los humanos tiene su quid. Se trata de confiar en algo. Un humano aprende a partir de la confianza en lo que recibe. En el aprendizaje automático la cosa es bien distinta, porque se basa en corregirle desde el tutelado si es o no correcto lo que se le dice. En la interpretación es donde se ponen de relieve los fallos de razonamiento de una IA. No cabe duda de que la clave está en centrar los modelos en prácticas de como razonan los humanos. Sigue siendo imprescindible el diálogo hombre máquina para desde la conversación habilitar la interpretación. Se trata de un avance colaborativo.

Estamos en un punto en el que los problemas a resolver tienen una entidad magnífica. Ha pasado más de una vez. En la década de los ochenta los sistemas expertos, basados en entrenamiento con humanos capaces en un área de conocimiento, aceptaban datos y reglas para su manejo y una vez entrenados los sistemas se ponían a producir, desde ámbitos como el mundo financiero, siempre atento a la reducción de personal y el funcionamiento seguro, hasta las prospecciones petrolíferas. La cuestión es que en aquella época los sistemas expertos ya fueron más económicos que los operadores humanos para ciertas tareas. Hoy nadie los usa. Pero hemos entrado en la IA. Todo es posible. Sin evidencias o por miedos, podemos decidir en algún momento, cuando el estado madure, que la tecnología hoy denominada IA, no es la apropiada para los humanos. Todo cabe. En todo caso, el uso ignorante de los sistemas solo conduce a la melancolía, y, eso sí, a enriquecer a unos cuantos. Ha pasado y está pasando. ¡Ojo!

Este blog pretende ser una depresión entre dos vertientes: la ciencia y la tecnología, con forma inclinada y alargada, para que por la vertiente puedan circular las aguas del conocimiento, como si se tratara de un río; o alojarse los hielos de un glaciar de descubrimiento, mientras tiene lugar la puesta a punto de su aplicación para el bienestar humano. Habrá, así, lugar para la historia de la ciencia, las curiosidades científicas y las audacias científico-tecnológicas. Todo un valle.

El eldense Alberto Requena es catedrático emérito de Química de la Universidad de Murcia.